bwZWM

Die Digitalisierung wissenschaftlicher Arbeitsplätze stellt die wissenschaftliche Praxis vor neue Herausforderungen. Dank moderner (digitaler) Technologien (z.B. neuartiger Sensoren oder Messgeräte) und Verfahren (Simulationen, Algorithmen) hat sowohl die Menge als auch die Heterogenität (automatisch) gemessener oder digital generierter Daten, sogenannter Born Digital Datasets, stark zugenommen. Während sich die institutionelle Einführung von Infrastruktur zur Erfassung und Erhaltung von wissenschaftlichen Primärdaten derzeit im Aufbau befindet oder teilweise schon existiert, entsteht parallel ein Problembewusstsein für die dazugehörigen Modelle und Methoden, insbesondere zur Datenauswertung. Für die Nachvollziehbarkeit und Transparenz von wissenschaftlichen Ergebnissen sind somit neue Werkzeuge und geeignete Dienstleistungen notwendig.

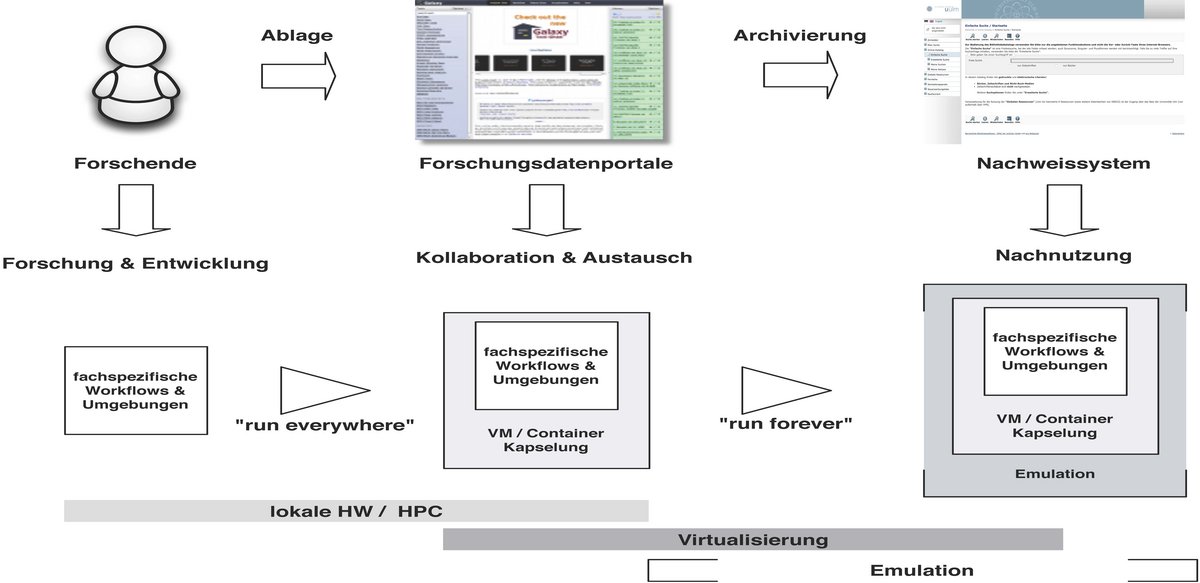

Das hier beantragte Vorhaben hat das Ziel, einen kooperativen, disziplinübergreifenden technisch-organisatorischen Dienst zu entwickeln, um Lehre und Forschung in der Weiterentwicklung “guter wissenschaftlicher Praxis” zu unterstützen, Daten und wissenschaftliche Methoden gemeinsam zitierfähig und reproduzierbar allgemein bereitzustellen, so dass beispielsweise die Anforderungen moderner Wissenschaftsjournale erfüllt werden können und die Nachnutzbarkeit von Forschungsdaten und Langzeitverfügbarkeit im Sinne eines modernen Forschungsdatenmanagements zu realisieren. Zur Erreichung der Projektziele haben sich drei der vier bwFor-HPC-Betreiber zusammengeschlossen, um prototypisch eine größere Breite in den Naturwissenschaften, insbesondere der rechen- und datenintensiven Wissenschaftsdisziplinen, abzudecken. Das Projekt greift hier bewusst auf bereits bestehende gemeinsame Erfahrungen und Lösungsansätze und wird diese disziplinunabhängig weiterentwickeln.

Um der Datenflut und der Komplexität wissenschaftlicher Forschungsdaten Herr zu werden, müssen den Forschenden, um erheblichen Arbeitsaufwand beim Umgang mit den Daten zu vermeiden, im Zuge der (Weiter-)Entwicklung digitaler Datenverarbeitungsmethoden einfach nutzbare und auf deren Bedürfnisse abgestimmte Dienstleistungen angeboten werden.

Während sich die institutionelle Einführung von Infrastruktur zur Erfassung und Erhaltung von wissenschaftlichen Primärdaten derzeit im Aufbau befindet1 oder z.T. schon existiert, entsteht parallel ein Problembewusstsein für die dazugehörigen Modelle und Methoden, insbesondere zur Datenauswertung. Jedoch existieren bis jetzt kaum nutzbare Infrastruktur- und Dienstangebote. In den DFG-Empfehlungen zur “guten wissenschaftlichen Praxis” wird derzeit zwar nur die Aufbewahrung der wissenschaftlichen Primärdaten empfohlen (http://www.dfg.de/foerderung/grundlagen_rahmenbedingungen/gwp, Empfehlung 7), in den weiteren Erläuterungen der Empfehlung wird allerdings auf “obligatorische” Aufzeichnungen der “Materialien und Methoden” verwiesen, die nicht nur für nachvollziehbare Ergebnisse notwendig sind, sondern “schon aus Gründen der Arbeitsökonomie in einer Gruppe ein zwingendes Gebot” sind. Sofern wissenschaftliche Ergebnisse reproduzierbar sein sollen, beispielsweise für eine unabhängige Verifikation (http://www.nature.com/news/independent-labs-to-verify-high-profile-papers-1.11176), ist eine Rekonstruktion des “Versuchsaufbaus” notwendig. Im digitalen Zeitalter mit seiner äußerst kurzen Lebensdauer (und Verfügbarkeit) von Hardware- und Software-Komponenten kann jedoch ein Nachbau eines in allen Komponenten identischen Datenverarbeitungsprozesses lediglich auf Grundlage von Aufzeichnungen nicht erreicht werden.

Für die Nachvollziehbarkeit und Transparenz von wissenschaftlichen Ergebnissen sind somit auch Methoden und Datenverarbeitungsprozesse in das institutionalisierte Datenmanagement von Hochschulen und Forschungseinrichtungen zu integrieren. Da zudem Modelle und Prozesse, die im Zeitalter von Big Data entwickelt werden, als eigenständige wissenschaftliche Beiträge angesehen werden, bedürfen sie auch einer unabhängigen, zitierfähigen Erhaltung.

Use Cases

Der Fokus des Projekts liegt auf datenintensiven und/oder rechenintensiven Forschungsbereichen in den Naturwissenschaften. Hierzu wurden vier relevante Fachbereiche in das Projektvorhaben integriert, mit denen bereits im bwHPC inklusive zugehöriger Kompetenzzentren enger Kontakt besteht. Im Zuge der Antragsvorbereitung fanden eine Reihe von Gesprächen mit verschiedenen Arbeitsgruppen statt. Vier Wissenschafts-Communities wurden im Vorfeld des Projekts ausgewählt.

Neuroscience (Freiburg): Das Bernstein Center in Freiburg steht stellvertretend für eine große verteilte Wissenschafts-Community im Bereich Neurowissenschaften

Bioinformatik (Tübingen / Freiburg): NGSEasy, Eine Containerisierte Next-Generation-Sequencing Pipeline Zentrum für Genetische Epidemiologie, Eberhard Karls Universität Tübingen

Computational Chemistry (Ulm): Für den HPC-Betreiber von ”JUSTUS” besteht das Problem, dass zunehmend Bedarf an reproduzierbaren Forschungsumgebungen gefordert wird. Dieses wurde im Zusammenhang des Cactos-Projekts insbesondere mit der Arbeitsgruppe “Theoretische Chemie” um Prof. G. Rauhut thematisiert.

Alle diese Bereiche arbeiten bereits oder experimentieren mit der (technischen) Beschreibung und Kapselung ihrer Datenverarbeitungsprozessen, beispielsweise als Container (Docker) oder virtuellen Maschinen. Des Weiteren gibt es domänenspezifische Lösungen zur Beschreibung der gekapselten Software und erste (domänenspezifische) Vorstellungen zur Beschreibung externer Abhängigkeiten. Die bisher verfügbaren Ansätze bieten jedoch noch keine zuverlässige Langfristperspektive bzgl. einer gesicherten Nachnutzbarkeit. Hier setzt das beantragte Projekt an und baut auf die disziplinspezifischen Ansätze auf. Sie bieten für das Projekt eine ausreichende Grundlage auf einer abstrakten Ebene, d.h. außerhalb der disziplinspezifischen Besonderheiten, zu arbeiten. Die Kapselung der technischen Prozesse (Software/Konfiguration) sowie deren inhaltliche, insbesondere fachspezifische Beschreibung bildet die Grundlage, die Projektziele der langfristigen Erhaltung und Zitierfähigkeit zu erreichen.

Die Use-Cases in den verschiedenen Fachdisziplinen illustrieren die Herausforderungen moderner Wissenschaft:

Es gibt kaum “einfache”, selbst-erklärende Forschungsdaten, die ohne ihren digitalen Kontext sinnvoll interpretier- und nachnutzbar sind;

Particle Physics (Karlsruhe / Freiburg): Thomas Hauth am Institut für Experimentelle Kernphysik ist Mitglied in der weltweiten CMS-Community.

komplexe Software-Umgebungen müssen reproduziert werden und reproduzierbare Forschungsergebnisse erzielen;

sowohl die in den Communities entwickelte oder kommerzielle Software ändert sich im Laufe der Zeit ebenso wie die genutzten Bibliotheken und Betriebssysteme und haben damit potenziell Auswirkungen auf die Forschungsergebnisse;

Methoden, Verfahren, Algorithmen sollen zwischen Arbeitsgruppen, die teilweise weltweit verteilt lokalisiert sind, ausgetauscht und verstanden werden;

insbesondere im Bereich der personalisierten Medizin ist die lückenlose Nachprüfbarkeit von computergestützten Analysen von größter Bedeutung, um ggf. Optimierungspotential oder Fehler in Befundungen zu identifizieren;

häufig ergibt sich im Zuge neuer wissenschaftlicher Erkenntnisse die Notwendigkeit, Analysen mit neuen Parametern bzw. neuen Referenzdaten erneut durchzuführen. Ein sinnvoller Vergleich der Ergebnisse ist nur bei genauer Kenntnis der gesamten Laufzeitumgebung und der Verwendeten Parameter möglich

Geplante Ergebnisse

Ergebnis dieses Projekts ist ein dezentral koordinierter Dienst, der eine gemeinsame Abstraktionsschicht für Nachweis und Langzeitverfügbarkeit von Software-Umgebungen für verlässliche Reproduktion von Forschungsergebnissen in den „Computational Sciences“ schafft. Dazu wird ein Cloud-basierter technischer Rahmen entwickelt, der durch variable Ressourcenallokation eine günstige Kostenstruktur schafft, so dass für die langfristige Erhaltung von Forschungsumgebungen im Wesentlichen nur Kosten durch tatsächliche Nachfrage bzw. Zugriffe entstehen.

Aus der Kooperation von vier Fachdisziplinen mit Informationszentren entstehen abgestimmte Workflows und Best-Practice Guides für das Forschungsdatenmanagement (FDM), die später auf weitere Gebiete in den Natur- und Geisteswissenschaften ausgedehnt werden können. Hierzu zählen die Unterstützung und Infrastrukturangebote in Richtung "guter wissenschaftlicher Praxis" und der Aufbau von Weiterbildungsangeboten im Bereich FDM insbesondere für den wissenschaftlichen Nachwuchs.

Projektstatus

geplante Laufzeit: 1. Februar 2016 bis 31.1. 2019, das Kick-Off Meeting findet am 18. April 2016 an der Universität Mannheim (Schloss) statt

Partner und Ansprechpersonen

Projektkoordination

Rechenzentrum Universität Freiburg

Dr. Klaus Rechert, klaus.rechert@rz.uni-freiburg.de

Prof. Dr. G. Schneider

Universität Tübingen

Jens Krüger

Felix Bartusch

Universität Ulm

Prof. Dr.-Ing. Stefan Wesner (KIZ)